🌋 생성형 AI 혁명과 인프라의 한계

생성형 AI는 이제 미래의 공상 과학이 아닌 바로 눈 앞에 다가왔습니다!

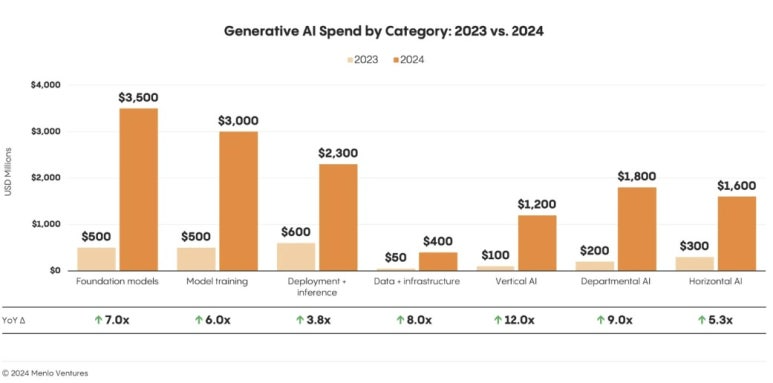

2024년 AI 지출은 130억 달러를 넘어섰고, 생성형 AI엔 전 세계 민간 투자 339억 달러를 갱신하였습니다.

하지만 이 폭발적 성장의 이면에는 “인프라 병목”이 존재하고, 아직 명확하게 해결하지 못한 상황입니다.

골드만삭스는 2030년까지 데이터센터 전력 사용이 160% 증가할 것으로 전망하였고, 전통적 퍼블릭 클라우드 (AWS, Azure, GCP) 는 더 이상 대규모 AI 워크로드를 감당하기 어렵습니다.

→ 명확한 해법은 기본기에 중점을 둔 베어메탈 GPU 인프라이며, 에이셔 같은 분산형 네트워크가 중앙집중 클라우드의 장벽 없이 엔터프라이즈급 성능을 제공합니다.

💸 클라우드의 숨은 비용: 성능 손실 & 이그레스 요금

가상화(VM)는 유연하게 동작하지만, 생성형 AI에선 오버헤드가 큰 문제점이 있습니다.

가상화 계층 때문에 GPU 성능이 15~30%까지 저하될 수 있고, 장기간·대규모 학습에선 이 손실이 곧 커다란 시간 손실과 비용을 발생하는 문제가 있습니다.

데이터 이그레스 요금(예: 대역폭 GB당 과금)까지 더해지면 미디어/콘텐츠 기업의 비용 구조는 급격히 악화됩니다. 실제로 많은 조직이 비용·프라이버시 이슈로 AI 워크로드를 퍼블릭 클라우드에서 회수하고 있죠.

→ 에이셔의 베어메탈은 투명한 가격, 이그레스 무료 모델로 숨은 비용을 제거합니다.

🚀 베어메탈 GPU: 고성능을 여는 정석

베어메탈은 하드웨어에 직접 접근해 가상화 오버헤드 0에 가까운 성능을 발휘합니다!

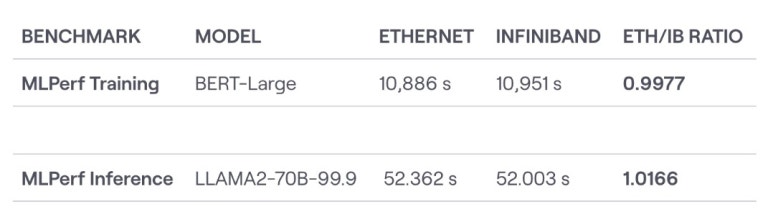

특히 대규모 분산 학습·추론에선 메모리 대역폭 최적화와 네트워크 지연이 승패를 결정하며, 인피니밴드(InfiniBand) 같은 고성능 인터커넥트는 수천 GPU 스케일에서도 μs(마이크로초) 단위 지연을 유지하도록 설계 되었습니다.

→ 전체 스택(하드웨어·네트워크·스토리지)을 최적화하면 속도 향상 + 비용 절감을 동시에 달성할 수 있습니다.

🎨 AI 워크로드 프로덕트 혜택

- LLM(대형 언어모델): 수천 GPU로 스케일하는 학습/추론, 긴 컨텍스트·멀티모달 모델에 필수.

- 이미지·비디오 생성: 실시간 렌더링, 대용량 배치 처리, 저비용 고대역 스토리지가 핵심.

- 오디오·음악 생성: 인터랙티브 서비스에 필요한 초저지연 성능을 베어메탈로 확보.

- 3D·가상 월드: GPU Direct, 분산 렌더링으로 더 사실적이고 대규모한 시뮬레이션 구현.

🧮 구축 vs 임대: GPU 인프라의 새로운 경제학

직접 구축하면 H100 한 장에 $25k~$40k, 8GPU 노드면 $200k가 금세 넘어갑니다(전력·냉각·운영 비용 제외). 반면 에이셔의 분산형 베어메탈을 임대하면 선투자 없이 연중 상시로 동일급 성능을 활용할 수 있고, 운영/유지비를 걱정할 필요가 없습니다.

→ 총소유비용(TCO) 40~80% 절감, 다수 워크로드는 6~12개월 내 손익분기가 현실적입니다.

🧱 기술 청사진: 고성능 AI 스택 설계 포인트

- GPU 선택: H100/H200부터 차세대 Blackwell(B200/GB200)까지 워크로드별 벤치로 결정.

- 네트워킹: InfiniBand / RoCE / 고급 이더넷 중 분산 학습 특성에 맞게 구성.

- 스토리지: VAST, DDN, WekaIO 등으로 고대역·저지연 데이터 파이프 확보.

- 클러스터 사이징: 8GPU 개발용 → 수천 GPU 슈퍼클러스터까지 점진 확장.

- → 에이셔는 전 세계 93개국·200+ 로케이션에 사전 최적화 구성을 갖춰, 복잡한 인프라 설계를 대신합니다.

🧭 마이그레이션 가이드: 리스크 없이 단계적 전환

- 1단계(파일럿): 비핵심/고가치 워크로드부터 이전, 성능·비용 벤치마크 확보.

- 2단계(하이브리드): 온프레미스/기존 클라우드와 병행 운영하며 연속성 보장.

- 3단계(확대): KPI 달성 시 점진적 전환. 팀 교육·운영 플레이북 정착.

- → 24~48시간 이내 배포와 엔터프라이즈 기술 지원으로 이행 리스크를 최소화합니다.

🌱 미래 로드맵: 분산형·지속가능한 AI 컴퓨트

차세대 GPU 아키텍처(Blackwell 등)로 성능은 도약하고, 분산형 인프라 + 재생에너지 결합이 가속됩니다. 베어메탈은 가상화 대비 에너지 효율도 우수해 비용·환경 두 마리 토끼를 잡습니다. 2025~2027년, 분산형 GPU 네트워크의 대중화와 워크로드 특화 인프라의 확산이 본격화될 전망입니다.

🌱 미래 로드맵: 분산형·지속가능한 AI 컴퓨트

차세대 GPU 아키텍처(Blackwell 등)로 성능은 도약하고, 분산형 인프라 + 재생에너지 결합이 가속됩니다. 베어메탈은 가상화 대비 에너지 효율도 우수해 비용·환경 두 마리 토끼를 잡습니다. 2025~2027년, 분산형 GPU 네트워크의 대중화와 워크로드 특화 인프라의 확산이 본격화될 전망입니다.

🗺️ 실행 로드맵 체크리스트

- 진단: 현 비용·성능 병목 파악, 이그레스/대역폭 숨은 비용 계량화.

- 파일럿: 장시간 학습·대역폭 집약형부터 이전, ROI 빠른 과제 우선.

- 지표: GPU-시간당 비용, 학습 시간 단축, 배포 속도, 자원 활용률.

- 파트너십: 에이셔와 같은 매니지드 베어메탈로 인프라 복잡도 제로화.

🔑 결론: 에이셔로 생성형 AI의 잠재력을 전부 끌어내기

베어메탈 GPU 클러스터는 성능·가격 투명성·직접 하드웨어 접근으로 다음 AI 혁신의 첫번쨰 기반이 됩니다.

에이셔의 분산형 베어메탈은 엔터프라이즈급 GPU를 전 세계 어디서나, 숨은 비용 없이 제공합니다. 지금 베어메탈로 전환하는 기업이 모든 생성형 기술의의 선두를 선점 할 수 있는 기회가 열려 있으며, 에이셔 클라우드는 가장 빠르고 확실하게 지원합니다!

📞 다음 단계

- 상담 요청: 에이셔 엔터프라이즈 팀과 요구사항을 논의하고, 최적의 베어메탈 구성을 제안 받으실 수 있습니다!

- 파일럿 시작: 24~48시간 내 배포, 첫 달에 성능·비용 효과를 눈으로 확인하세요.

- 확장: 필요 시 수백~수천 GPU로 즉시 스케일업. 이그레스 요금 없이 글로벌로 확장 가능합니다.

에이셔의 분산형 베어메탈 GPU로 고성능 생성형 AI를 지금 바로 가동해 보세요!

.jpg)

_Blog_1910x1000_V3.jpg)